【东大新闻网3月29日电】(通讯员 杨旭)近日,东南大学计算机科学与工程学院、软件学院、人工智能学院PALM实验室耿新、杨旭团队全球率先开源面向视觉语言多模态大模型的强化学习开源框架LMM-R1。该成果通过创新性技术路径,在智能体复杂推理任务中实现3B小模型超越百倍参数量级商业产品的突破。

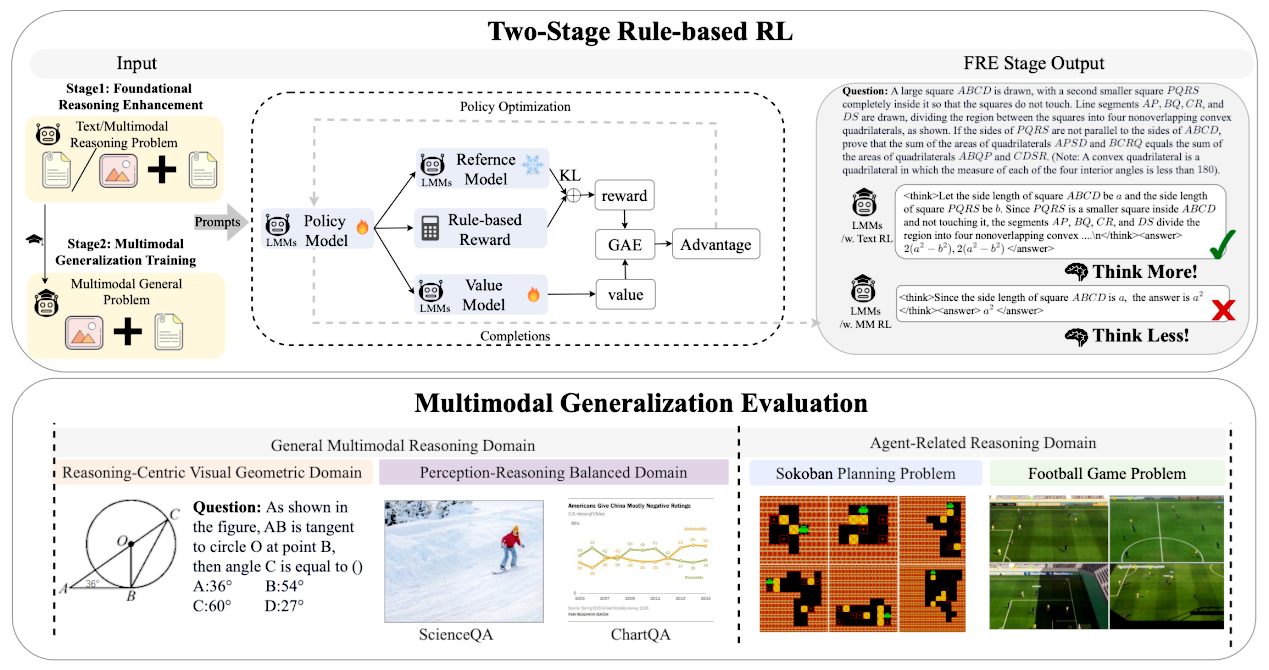

该框架针对多模态领域长期存在的“高训练成本、低任务泛化”难题,创新引入规则化奖励函数机制,在无需多模态标注数据支持下,仅需百元GPU成本即可完成训练,使LMM-R1框架强化的QwenVL-2.5-3B模型在复杂路径规划任务中超越GPT-4o、Claude3.5等100B+参数量产品级大模型。通过自主研发的纯文本数据迁移方案与高性能代码框架,该模型使得多模态训练效率提升500%,并构建起支持16k长上下文的训练体系,为智能体决策系统提供了可落地的技术解决方案。

该框架基于上游项目OpenRLHF自主研发,在智能体应用场景验证中也展现出卓越性能。其独创的“PackingSample + Ring FlashAttention”技术使模型上下文长度实现GPU数量线性增长,配合动态梯度裁剪策略,在推箱子等需多模态协同推理的任务中,仅凭初始画面即可规划完整动作序列。

自2025年2月开源以来,LMM-R1框架迅速获得同行广泛关注,相关技术方案已被多个知名开源项目采纳为基准架构。目前,该项目已在GitHub平台建立独立技术生态,累计获得超过600+星标关注,标志着我国在多模态强化学习领域取得重要突破。

论文地址:https://arxiv.org/abs/2503.07536

项目地址:https://github.com/TideDra/lmm-r1

供稿:计算机科学与工程学院 软件学院 人工智能学院

(责任编辑:周子琪 审核:李震)